Estratégias para Orientação do Uso Ético e Eficiente de IA na Produção Acadêmica

Uma Conversa que Mudou Perspectivas

Em 2 de julho de 2025, durante uma conversa espontânea, uma amiga que está fazendo doutorado me questionou sobre o uso de IA no desenvolvimento da pesquisa científica, desde como isso é visto tecnicamente até o benchmarking nacional e internacional.

A pergunta surgiu de forma despretensiosa, mas revelou uma inquietação genuína sobre como pesquisadores devem navegar entre inovação tecnológica e integridade acadêmica.

Hoje, é tendência entre pesquisadores, decisores e lideranças recorrer a ferramentas como o ChatGPT, justificando que elas potencializam e promovem a produtividade, além de promover uma amplificação cognitiva e eficiência na qualidade dos textos e das próprias pesquisas: sim, estamos vivendo uma febre que precisa de cautela.

O débito cognitivo, um conceito central nesta discussão, ocorre quando o uso indiscriminado de IA substitui etapas essenciais do desenvolvimento cognitivo, como análise e criação, comprometendo a originalidade e a profundidade do pensamento humano.

Essa preocupação moldou nossa conversa, destacando a necessidade de posicionar a IA como ferramenta de amplificação, e não como substituta do raciocínio crítico.

Minha resposta foi direta: o uso da IA pode ser transformador, desde que esteja vinculado a uma cadeia de raciocínio bem estruturada, em que o confronto de ideias parte do repertório humano prévio, gerando insights valiosos — mesmo considerando as inferências probabilísticas dos LLMs.

Taxonomia de Bloom: Amplificação Cognitiva e os Impactos da IA

Mais do que uma resposta pautada no conhecimento técnico sobre IA, optei por me posicionar como educador. Expliquei a partir de um exemplo como o desenvolvimento cognitivo humano segue uma progressão hierárquica conforme a proposta da Taxonomia de Bloom categorizada em seis níveis, do mais simples ao mais complexo:

- Lembrar, Compreender, Aplicar, Analisar, Avaliar e Criar.

Exemplo proposto: para ilustrar, citei como meu filho Pedro, hoje com 2 anos e 11 meses, está vivenciando essa progressão cognitiva de forma natural e estimulada por vivências.

Tomando por base uma atividade chamada de “Retratos de Família” (Campo de Experiência “O eu, o outro e o nós”, da BNCC), demonstrei essa progressão por meio de verbos específicos associando uma resposta de ação com o respectivo nível:

| Nível Cognitivo | Verbos Utilizados | Resposta de Ação do Pedro |

|---|---|---|

| Lembrar | Reconhecer, identificar, recordar | Reconhece rostos familiares em fotos, identifica “mamãe” e “papai” |

| Compreender | Explicar, descrever, interpretar | Explica relações simples (“mamãe dá beijinho”), descreve ações familiares |

| Aplicar | Usar, demonstrar, aplicar | Usa conhecimento para se reconhecer no espelho, demonstra afeto imitando gestos |

| Analisar | Comparar, contrastar, examinar | Compara características físicas, contrasta diferenças entre familiares |

| Avaliar | Julgar, avaliar, criticar | Julga semelhanças (“Pedro igual papai”), avalia preferências familiares |

| Criar | Desenhar, construir, inventar | Desenha sua família, constrói narrativas sobre fotos, inventa brincadeiras familiares |

Esse caminho hierárquico é essencial ao desenvolvimento cognitivo, pois cada etapa se constrói de forma orgânica sobre a anterior.

Da mesma forma quando um pesquisador substitui esse processo por uso de LLMs — que apenas reorganizam informações de forma probabilística (veja o vídeo abaixo)—, está comprometendo a construção genuína do pensamento e, ainda, sobrecarregando o cérebro.

Embora modelos avançados possam simular raciocínios pontuais, não geram reflexão autêntica. O ponto central não é a incapacidade da IA, mas como seu uso pode preservar ou prejudicar o desenvolvimento cognitivo, especialmente desde a infância, onde a progressão natural envolve verbos de ação específicos.

Portanto, para tarefas básicas (lembrar, compreender), os LLMs podem ser úteis. No entanto, em níveis superiores de cognição (avaliar, criar), o controle humano continua sendo indispensável para evitar a atrofia cognitiva e reduzir o risco de plágio acadêmico.

MIT: A Sua Mente no ChatGPT

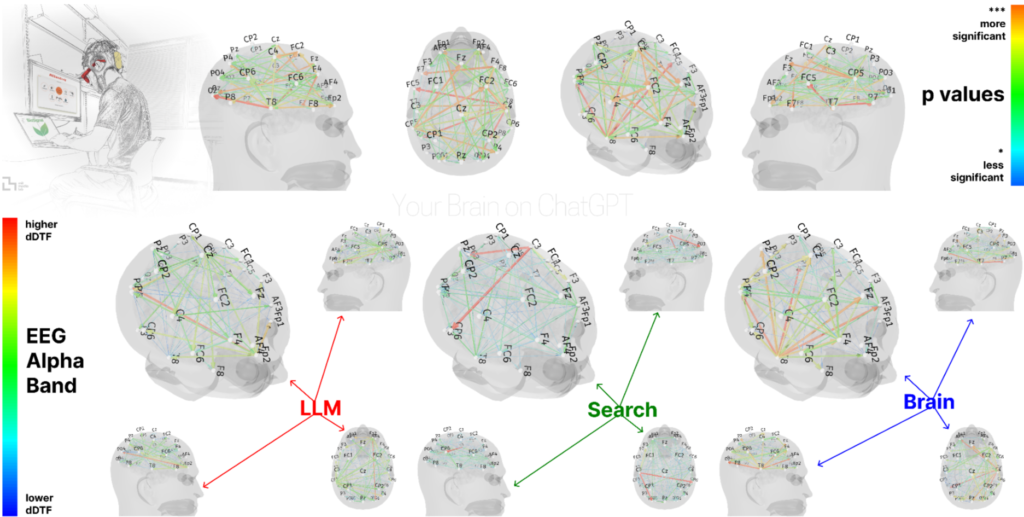

25 de junho de 2025 — Bem, apenas 7 dias antes de nossa conversa espontânea, o MIT Media Lab havia divulgado o estudo “Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task“.

O timing foi notável: as preocupações já contam com (certa) validação científica, tornando nossa conversa ainda mais relevante e direcionada para o campo educacional quanto ao desenvolvimento cognitivo de pesquisadores.

Metodologia e Resultados Detalhados:

Amostra: 55 participantes (18-39 anos, região de Boston)

Metodologia: Ensaios SAT de 20 minutos com monitoramento EEG em 32 regiões cerebrais

Grupos: ChatGPT vs. Google Search vs. sem ferramentas

Limitações: Amostra pequena e geograficamente restrita, contexto específico (ensaios SAT), sem revisão por pares

Resultados quantitativos:

- 35% redução na atividade cerebral nas áreas pré-frontais (grupo ChatGPT vs. grupo controle)

- 20% menos originalidade nas ideias produzidas

- 15% mais erros gramaticais sutis, indicando menor engajamento crítico

- Google Search: posição intermediária (10% redução vs. controle)

Interpretação crítica: O estudo, embora limitado em escopo, oferecia validação científica recente para as preocupações que emergiram naturalmente em nossa discussão.

Os resultados se aplicam especificamente ao uso irrestrito em tarefas de escrita, não necessariamente a usos estruturados ou supervisionados, mas forneceram o contexto científico que tornou nossa conversa ainda mais presciente.

Validação de análise prévia: O estudo do MIT corroborou exatamente os cinco pontos que havia identificado e sinalizado em outro texto publicado em março de 2025 sobre regressão cognitiva na cadeia de liderança:

- Declínio prático da inteligência (confirmado pela redução de 35% na atividade pré-frontal)

- Redução no foco sustentado (evidenciado pelos 15% mais erros gramaticais)

- Queda no raciocínio crítico (demonstrado pela 20% menos originalidade)

- Transição para consumo passivo (usuários aceitando outputs sem questionamento)

- Impacto negativo dos estímulos digitais (dependência crescente de respostas automatizadas)

Panorama Global: Posicionamento Institucional

Instituições Internacionais de Referência e Diretrizes Específicas:

| Instituição | Posicionamento | Diretrizes Específicas |

|---|---|---|

| MIT | Colaborativo controlado | Investimento de US$50M no programa NextGenAI com a OpenAI para pesquisas em saúde, engenharia e humanidades |

| Harvard | Restritivo por curso | “Proibimos especificamente o uso de ChatGPT em todas as etapas do processo de trabalho” |

| Oxford | Moderado ético | “IA não pode substituir pensamento crítico humano ou desenvolvimento de argumentos baseados em evidências” |

| Universidade de São Paulo | Restritivo | Alertas sobre uso de ChatGPT; discussões sobre regulamentação |

Instituições Brasileiras – Diversidade Regional:

| Instituição | Região | Posicionamento | Contexto Local |

|---|---|---|---|

| USP | Sudeste | Restritivo | Recursos amplos, foco em pesquisa |

| UFRJ | Sudeste | Moderado | Equilíbrio entre inovação e tradição |

| UFMG | Sudeste | Restritivo | Programas consolidados, rigor acadêmico |

| UFBA | Nordeste | Em debate | Discussões regionais sobre acesso |

| UFSC | Sul | Moderado | Forte área tecnológica |

| UFAM | Norte | Adaptativo | Foco em inclusão digital |

Observação crítica: As diretrizes tendem a ser mais restritivas em instituições com recursos abundantes e mais adaptativas em contextos de recursos limitados, sugerindo que o acesso equitativo à IA educacional requer abordagens diferenciadas por contexto socioeconômico.

Potencializando LLMs para Autenticidade Intelectual

Para pesquisadores acadêmicos

A discussão se estendeu e foi revelando outra questão fundamental: como, então, podemos/devemos utilizar diferentes modelos de IA para potencializar resultados positivos na produção científica, preservando autenticidade intelectual?

Diante do risco de débito cognitivo — a substituição de etapas essenciais do pensamento humano por ferramentas de IA —, torna-se crucial adotar estratégias que maximizem os benefícios dos LLMs sem comprometer a originalidade e o rigor acadêmico.

Nessa linha, fiz um esboço para tangibilizar essa discussão, propondo aplicações específicas para diferentes modelos de IA, conforme detalhado abaixo.

| Modelo | Aplicação Estratégica | Preservação de Autenticidade | Protocolo Recomendado |

|---|---|---|---|

| ChatGPT o3 | Mapeamento inicial de literatura, estruturação de argumentos | ⚠️ Moderado — requer supervisão constante | Níveis 1-2 apenas |

| Claude 4.0 | Análise de documentos extensos, revisão crítica | ✅ Alto — preserva a lógica argumentativa | Níveis 1-3 com supervisão |

| Gemini 2.5 | Pesquisa bibliográfica, contextualização histórica | ✅ Alto — funciona como biblioteca expandida | Níveis 1-2 recomendados |

| Perplexity | Verificação factual, fontes atualizadas | ✅ Muito Alto — transparência total de fontes | Todos os níveis para verificação |

Modelos de LLMs por Objetivo da Pesquisa:

- Exploração: Gemini 2.5 + Perplexity (contexto + verificação)

- Estruturação: Claude 4.0 (preserva lógica)

- Verificação: Perplexity (fontes transparentes)

- Análise complexa: Supervisão humana obrigatória, independente do modelo

Este framework orienta pesquisadores a usar LLMs de forma ética e estratégica, alinhando-se aos níveis cognitivos da Taxonomia de Bloom e minimizando os riscos de débito cognitivo, garantindo que a IA amplifique, e não substitua, o pensamento humano.

Vamos a um Exemplo Prático?

Simulação da CBS em Homenagem à Reforma Tributária

Cenário: Desenvolver uma pesquisa em Direito Tributário analisando “Os impactos da Contribuição sobre Bens e Serviços (CBS) no federalismo fiscal brasileiro”.

❌ Uso Problemático (Alto Débito Cognitivo): “ChatGPT, escreva minha análise sobre os impactos da CBS na autonomia dos estados e municípios, incluindo jurisprudência do STF e comparação com sistemas internacionais”

- Problema: Substitui completamente análise jurídica especializada

- Risco: Argumentação genérica sem compreensão das nuances federativas

- Impacto na tese: Perda total de originalidade jurídica

✅ Uso Estratégico (Preserva Autenticidade):

Protocolo Sequencial:

- Gemini 2.5 (Nível 1): “Mapeie toda legislação federal sobre CBS de 2023-2025 e identifique marcos normativos relevantes”

- Perplexity (Nível 1): “Confirme vigência dessas normas e identifique eventuais ADIs no STF sobre CBS”

- Claude 4.0 (Nível 2): “Analise contradições entre os artigos que identifiquei nos estudos de impacto federativo. Onde há lacunas interpretativas?”

- Análise Humana (Nível 3-4): Pesquisador desenvolve tese original sobre “CBS como instrumento de recentralização tributária disfarçada” baseado nas lacunas identificadas

Resultado: Tese original sobre tensão federativa não explorada na literatura, usando IA como amplificador de pesquisa, não substituto de análise jurídica.

Contribuição inédita: Framework teórico conectando CBS, federalismo fiscal e autonomia municipal – impossível de ser gerado por IA, mas potencializado por ela.

Proposta de Protocolo para Uso Responsável de IA em Pesquisa

| Nível | Classificação | Atividades Permitidas | Supervisão | Declaração | Risco Cognitivo |

|---|---|---|---|---|---|

| 1 | Exploração | • Mapeamento de literatura • Identificação de lacunas • Organização de referências | Mínima | Obrigatória | ✅ Baixo |

| 2 | Estruturação | • Organização de argumentos desenvolvidos • Revisão de coerência metodológica • Formatação de citações | Ativa | Obrigatória com detalhamento | 🔄 Moderado |

| 3 | Análise | • Interpretação de dados • Desenvolvimento de frameworks teóricos • Síntese de resultados | Constante | Obrigatória com justificativa científica | ⚠️ Alto |

| 4 | Criação | • Formulação de conclusões originais • Redação de contribuições inéditas • Desenvolvimento de teses centrais | N/A | Uso compromete autoria | 🚫 Crítico |

Legenda de Risco Cognitivo:

- ✅ Baixo: Preserva desenvolvimento cognitivo, funciona como biblioteca inteligente

- 🔄 Moderado: Requer atenção para manter controle analítico

- ⚠️ Alto: Risco significativo de substituição do pensamento crítico

- 🚫 Crítico: Compromete autenticidade e contribuição científica original

O Uso Sob a Perspectiva do Especialista

Antonio Carlos de Aguiar, especialista em Direito, alerta sobre “a necessidade inegociável da leitura e os perigos da preguiça intelectual gerada por IA no Direito”.

Ele exemplifica: “há petições que repetem jurisprudência que o autor não conferiu se de fato existiam; são citadas doutrinas clássicas de livros cujas capas o peticionário desconhece”.

Sua solução: “voltando-se às fontes: lendo livros, jurisprudência e doutrina na sua origem, não as consumindo em fragmentos”, pois “o Direito exige precisão. Não há espaço para qualquer tipo de preguiça intelectual”.

Conclusão: A Pesquisa Responsável

Um encontro que aconteceu como uma mera atualização revelou questões replicáveis não apenas para pesquisadores, mas para decisores e todas as situações em que o uso do ChatGPT vem ganhando espaço.

Esse diálogo expôs um desafio crucial para a humanidade: como integrar a inteligência artificial para potencializar a criatividade, sem incorrer em débito cognitivo que comprometa a autenticidade do conhecimento que nos diferencia das máquinas?

A resposta está em adotar a IA como uma aliada estratégica, guiada por transparência, supervisão ativa e um compromisso com a originalidade. Seja na academia, na gestão ou em outros campos, o futuro do conhecimento depende de posicionarmos a IA como uma ferramenta que amplia horizontes, mantendo o pensamento crítico humano como protagonista.

Sua próxima decisão: Vai usar a IA como um tutor socrático que fortalece seu raciocínio — ou como um substituto cognitivo que compromete suas capacidades humanas essenciais?

Teixeira Júnior é Diretor Executivo de Inovação, Educação e Impacto, palestrante e especialista em soluções para educação, negócios e tecnologia. Cearense, atua no desenvolvimento de projetos de neuroaprendizagem, currículo e uso responsável da inteligência artificial, com foco em impacto comprovado na aprendizagem de redes públicas e privadas.

É, também, Embaixador Científico da Olimpíada Nacional de Inteligência Artificial e pioneiro em modelos de ensino adaptativo em larga escala no Brasil. Recebeu prêmios como o Plurall Adapta (2021), a lista As 100+ Inovadoras no Uso de TI (IT Mídia, 2021), finalista do Innovation Hack da SOMOS Educação e ACE Cortex II (2022), além de outros reconhecimentos internacionais, tais como Gates Millennium Scholars Program (2008) e o título de Outstanding Educator da University of Chicago (2017).

Referências e Leitura Complementar

Estudos Científicos:

- MIT Media Lab (2025). “Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task”

- Financial Times (2025). “Have humans passed peak brain power?”

- OECD PISA, PIAAC and Adult Literacy and Lifeskills Survey

Artigos Relacionados:

- Teixeira Júnior (2025). “Impactos da IA na Cognição: Novo Desafio para a Liderança Estratégica”

- Antonio Carlos de Aguiar (2025). “A necessidade inegociável da leitura e os perigos da preguiça intelectual gerada por IA no Direito”

Diretrizes Institucionais:

- Harvard University Guidelines for AI Use in Academic Work

- Oxford University AI Guidelines for Students

- MIT NextGenAI Partnership Documentation

Frameworks Técnicos:

- Base Nacional Comum Curricular (BNCC) – Campo de Experiência “O eu, o outro e o nós”

- Taxonomia de Bloom – Desenvolvimento Cognitivo Hierárquico

- IEEE Ethically Aligned Design para IA Responsável